数据科学中的对比学习:告别海量标注,解锁表征学习新范式

引言:破解表示学习的效率困局

你是否曾疲于在数据标注的泥潭中挣扎?是否苦于特定任务训练出的模型无法有效迁移?面对无标签数据的广袤“深矿”,我们是否只能依赖昂贵的人工标注?

传统监督学习虽然强大,却严重依赖大量精准标注数据,成本高昂、灵活性低,且学习到的特征往往陷入任务特定的“狭窄”范畴,难以泛化。表示学习——即让模型自动捕捉数据内在结构和本质特征的能力——成为突破瓶颈的关键。而对比学习(Contrastive Learning),正以其利用数据本身关系进行自监督训练的革新方式,成为当下最耀眼的技术范式之一。

想象一个孩童认知世界:他无需大人逐点标注“这是猫的胡须,那是猫的耳朵”,而是通过观察不同猫的相似点(胡须、耳朵、叫声),以及与狗的不同之处,自然建立起“猫”的概念模型。对比学习的核心思想与此惊人相似:不依赖外部标签,让模型通过比较数据点间的异同,自动发现隐藏的模式,学习通用且强大的数据表示。

本文旨在系统剖析对比学习的原理、核心方法、实践案例与未来趋势,助你在数据科学领域迈入高效学习的新征程。

第一部分:概念基础 —— 什么是对比学习?为何重要?

表示学习(Representation Learning)的核心地位:

任务实质:将原始数据(图片、文本、声音)转化为更易机器理解、包含关键信息的向量(嵌入/Embedding)。目标:这些表示应具备不变性(同类数据不同视角/变形下表示相似)、判别性(不同类数据表示差异显著)、通用性(能支持多种下游任务)。 监督学习的桎梏:

标注依赖瓶颈: 高质量标注数据获取昂贵且耗时,成为许多应用(如医疗影像)发展的拦路虎。任务特定狭隘性: 为任务A训练的模型,其学到的表示对任务B可能效果很差,缺乏通用性。人类先验局限: 标注定义依赖于人类对任务的理解,可能忽略数据的潜在结构。 自监督学习(Self-Supervised Learning)的曙光:

核心思想:从数据本身产生监督信号!通过巧妙设计预定义任务(Pretext Task),利用数据未被标注的属性(如顺序、空间关系、颜色通道)来生成伪标签。目标:学习通用表示,可迁移到下游任务。 对比学习(CL)的定义与范式突破:

定义: 一种自监督学习方法框架,其核心训练目标是让模型学习区分相似(正样本对)与不相似(负样本对)的数据点。模型通过最小化相似样本间的距离,最大化不相似样本间的距离来学习。范式特点:

关系驱动: 关注样本点间的关系,而非单个样本本身。核心构件: 正样本构造策略、负样本构造策略、对比损失函数。通用表示: 核心目标是学到数据分布固有的结构信息,天然利于迁移学习。 对比学习的杀手锏优势:

摆脱标注依赖: 极大减少或完全消除对人工标注的需求。学习通用特征: 捕捉数据本质结构与不变性,迁移到各类下游任务效果优异。鲁棒性增强: 对噪声、变形等具有一定容忍度。潜力巨大: 特别适用于处理海量无标注数据资源。

第二部分:核心原理与关键技术拆解

核心思想公式化表达:

对于一个锚点样本

,其对应的增强正样本

x应被拉近,而与一个或多个负样本

x+的距离应被推远。

{x1-, x2-, ..., xN-}

如何实现?让我们分解关键技术组件:

锚点与正样本构造:数据增强的艺术

关键作用: 为单个数据点

x

t(x)

t'(x)

空间:裁剪 (Random Cropping – 至关重要!)、旋转、翻转、扭曲。外观:颜色抖动、灰度化、模糊、噪声、Cutout / CutMix。数据混合:MixUp(需谨慎,可能引入混淆)。 设计原则 (InfoMin Principle):

增强

t

x

t(x)

x

t(x)

负样本策略:效率与质量的博弈

目的: 为锚点提供“异类”参照物,帮助模型明确边界。方式:

批次内负样本 (In-batch Negatives): 将同一训练批次中除正对外的所有其他样本视作锚点的负样本。实现简单、计算高效,最常用。显式记忆库 (Memory Bank, MoCo引入): 存储历史样本的特征作为额外负样本源,增加负样本数量和一致性。动量编码器 (MoCo改进): 使用动量更新的缓慢演进的目标编码器 (Momentum Encoder) 提取查询样本特征存入记忆库,解决记忆库特征过时问题。(平衡表示一致性、批次大小、更新速度的核心创新!)聚类负样本 / 难负样本挖掘 (Hard Negatives Mining): 仅选择与锚点相似度较高的样本作为负样本,避免简单负样本主导训练,提高学习效率,但实现更复杂。 负样本困境 (Negatives Collapse) 与应对: 过多负样本可能导致性能饱和甚至下降。SimCLR证明增加批次大小或使用记忆库比单纯增加负样本更有效。

编码器与投影头:特征提取的管道

编码器 (Encoder,

f(·)

h = f(x)

h

g(·)

h

z = g(h)

h

损失函数:相似度衡量的核心驱动力

目标函数本质: 最大化

x

x+

(z, z+)

x

x-

z_i

公式:

L_{ ext{InfoNCE}} = -log frac{exp( ext{sim}(z_i, z_j) / au)}{sum_{k=1}^{N} mathbb{I}_{[k

e i]} exp( ext{sim}(z_i, z_k) / au)}

(z_i, z_j)

sim(u, v)

u^T v / (||u|| ||v||)

τ

N

(N)

z_i

NT-Xent (Normalized Temperature-scaled Cross Entropy Loss – SimCLR):本质同 InfoNCE,强调归一化操作。Triplet Loss (较早期):每个训练样本为三元组

(x, x+, x-)

BYOL (Bootstrap Your Own Latent): 通过不对称结构(在线Encoder+EMA目标Encoder)和预测器,让一个视角预测同一张图的另一视角特征,避免负样本需求。SimSiam (Simple Siamese): 核心是

预测器+

停止梯度

第三部分:经典模型架构演进史

先行者:无监督嵌入学习的基础

SimCLR (A Simple Framework for Contrastive Learning of Visual Representations – 2020):

核心: 强大的数据增强(随机裁剪+色彩抖动是关键)、引入非线性投影头、大批次训练(可配合TPU)。结构: 对输入数据

x

t, t'

f(·)

h, h'

g(·)

z, z'

(z, z')

效率优化与大负样本库:MoCo (Momentum Contrast – 2019, v1/v2)

核心问题: SimCLR 依赖大批次(4096)获取足够负样本 -> 需要大量计算资源(TPU/超多卡)。突破点:

动量编码器 (

f_k(·)

k

在线分支:输入增强视图

x_q

f_q(·)

q

x_k

f_k(·)

k

q

k

{k0, k1, ..., k_{size-1}}

无需负样本的突破:BYOL (Bootstrap Your Own Latent – 2020) & SimSiam (2020)

核心挑战: 负样本构造、维护成本高,性能可能受负样本质量影响或崩溃。BYOL核心思想:

两个分支(在线分支

θ

ξ

x_q

f_θ, g_θ, q_θ

p_θ

p_θ(q_θ)

x_k

f_ξ, g_ξ

q_ξ

p_θ(q_θ)

q_ξ

单编码器

f(·)

x1 -> f -> h1 -> P(预测器)-> p1

x2 -> f -> h2

p1

detach(h2)

L = - (p1·h2_stopgrad) / (||p1||·||h2_stopgrad||)

迈向大规模:自监督Transformer与多模态扩展

DINO:Self-Distillation with NO Labels:

利用教师-学生架构,教师模型参数为学生模型的指数移动平均 (EMA)。输入图像的不同裁剪视图(全局视图给教师,局部视图给学生)。利用交叉熵损失让学生预测教师的输出(一个概率分布),使用自注意力图特征效果更佳。适配于 ViT/CNN 架构。 多模态对比学习 (CLIP, ALIGN):

核心:利用图像-文本的自然配对信息作为监督信号。架构:双编码器(

T(·)

I(·)

(image_i, text_i)

I(image_i)

T(text_i)

第四部分:实战 —— 如何在CV项目中应用对比学习?

案例目标: 训练一个通用特征提取器,用于下游医疗影像分析任务(如肺炎检测),但专业标注数据极度稀缺。

方案步骤:

构建无标签医学图像数据集:

获取大量CT/X光扫描原始图像(无需诊断标签)。

预训练自监督模型(以MoCo v2为例):

# 伪代码示例 - 基于PyTorch库

import torch

import torchvision.transforms as T

import torch.nn as nn

# 1. 定义增强(医疗影像特有增强?如模拟不同密度、弹性形变?)

transform = T.Compose([

T.RandomResizedCrop(224), # 随机裁剪(重要!)

T.RandomHorizontalFlip(), # 水平翻转

T.ColorJitter(0.4, 0.4, 0.4), # 颜色抖动

T.GaussianBlur(kernel_size=(5,5), sigma=(0.1, 2.0)), # 高斯模糊

T.ToTensor(),

])

# 2. 创建数据加载器 (伪代码)

unlabeled_dataset = MedicalImageFolder(root_dir, transform=transform) # 未标注数据

unlabeled_loader = DataLoader(unlabeled_dataset, batch_size=128, ...)

# 3. 模型定义 (简化的MoCo v2结构)

encoder_q = resnet50(pretrained=False) # 查询编码器 (在线)

encoder_k = resnet50(pretrained=False) # 键编码器 (动量/目标)

projection_q = nn.Sequential(nn.Linear(2048, 2048), nn.ReLU(), nn.Linear(2048, 128)) # 查询投影头

projection_k = nn.Sequential(nn.Linear(2048, 2048), nn.ReLU(), nn.Linear(2048, 128)) # 键投影头

# 初始化:让初始k和q参数相同

encoder_k.load_state_dict(encoder_q.state_dict())

projection_k.load_state_dict(projection_q.state_dict())

# 设置动量编码器不计算梯度!

for param in encoder_k.parameters():

param.requires_grad = False

for param in projection_k.parameters():

param.requires_grad = False

# 4. 动量更新函数 (EMA)

def momentum_update(model_q, model_k, m=0.999):

for param_q, param_k in zip(model_q.parameters(), model_k.parameters()):

param_k.data = param_k.data * m + param_q.data * (1. - m)

# 5. 损失函数 (InfoNCE变种)

contrastive_loss = nn.CrossEntropyLoss() # Q * K^T 相似度矩阵视为分类logits

# 6. 预训练循环

queue = MemoryBankQueue(size=65536) # 记忆队列

for images in unlabeled_loader: # images: [N, C, H, W]

# 准备两组增强视图

view1 = transform(images) # 实际应用中view1和view2应不同!这里简写

view2 = transform(images)

# 在线分支 (query encoder + projection)

q = encoder_q(view1) # [N, 2048]

q = projection_q(q) # [N, 128]

q = nn.functional.normalize(q, dim=1) # L2归一化重要!

# 目标分支 (key encoder + projection) 计算特征但不回传梯度

with torch.no_grad(): # 重要!

momentum_update(encoder_q, encoder_k, m=0.999) # EMA更新目标参数

momentum_update(projection_q, projection_k, m=0.999)

k = encoder_k(view2) # [N, 2048]

k = projection_k(k) # [N, 128]

k = nn.functional.normalize(k, dim=1)

# 计算对比损失 (logits: Nx(N+K)) N为当前批大小, K为队列长度)

# 正样本:q_i 和 k_i 对应

# 负样本:队列中所有键 + 当前批中除k_i外的所有键

logits = torch.mm(q, torch.cat([k, queue.get()], dim=0).t()) # [N, (N+K)]

labels = torch.arange(0, logits.size(0), dtype=torch.long).to(device) # 0,1,2...N-1 每个i对应k_i为正样本

loss = contrastive_loss(logits / temperature, labels)

# 更新队列:将当前k加入队列,移除旧的

queue.enqueue_dequeue(k)

loss.backward()

optimizer.step()

迁移学习(线性评估):

冻结预训练好的

encoder_q

projection_q

encoder_q

结果预期:

相较于在少量标注数据上从头监督训练的模型,使用对比学习预训练特征的模型准确率显著提升(通常提升10%-30%以上)。模型展现出更强的鲁棒性和泛化能力。

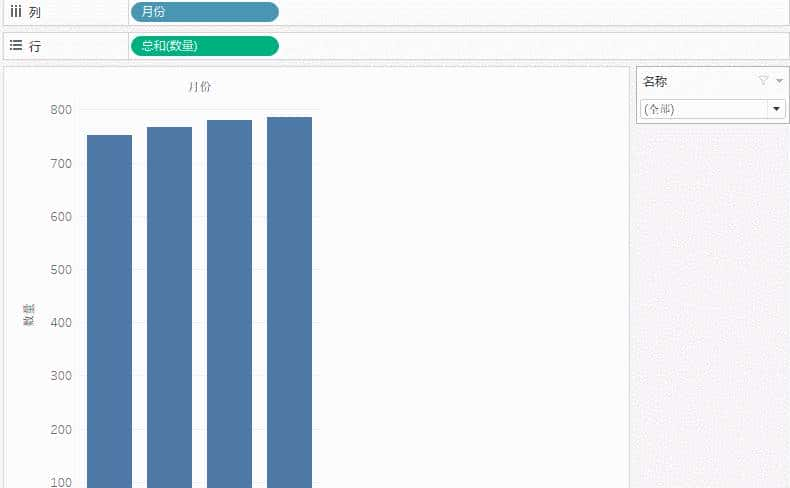

表:不同方法在小型医学影像分类数据集上的效果对比(示例)

| 方法 | 所需标注图像 | 肺炎检测准确率 (%) | 备注 |

|---|---|---|---|

| 监督学习 (ResNet50) | 全部 (5K) | 92.5% | 需要大量标注成本高昂 |

| 监督学习 (ResNet50) | 100张 | 68.3% | 严重过拟合,泛化性差 |

| SimCLR预训练 + 线性分类 | 100张 | 83.7% (+15.4%) | 显著提升!利用大量无标签数据 |

| MoCo v2预训练 + 线性分类 | 100张 | 85.1% (+16.8%) | 利用大负样本库可能更优 |

第五部分:超越视觉 —— 对比学习的广阔天地

对比学习的威力早已突破计算机视觉的范畴,在诸多领域展现强大潜力:

自然语言处理 (NLP):

SimCSE: 简单有效的句子表示学习:对同一句子进行两次不同的Dropout,产生两个视图作为正对,批次内其他句子为负样本。Debiased InfoNCE: 解决文本对比学习中因批次内假阴性(语义相近但未被标注为同一话题)导致的偏差问题。 语音处理:

wav2vec 2.0 / HuBERT: 对比学习用于自监督语音表示学习:预测被遮盖的语音段,同时区分正确段与干扰段(负样本)。 图表示学习 (Graph Representation Learning):

GRACE: 对原图进行随机扰动(节点/边丢弃、特征遮盖)生成两个增广图视图,最大化互视图节点嵌入一致性。DGI: 最大化图整体表示(Summary Vector)与其不同视角下节点表示之间的一致性。 强化学习 (RL):

CURL: 利用对比学习为高维状态(如像素输入)学习紧凑表示,提升RL算法的样本效率和泛化能力。DrQ: 结合对比学习与Deep Q-Network。 推荐系统:

SGL / SimGCL: 通过图结构上的对比学习增强用户/物品表示:对用户-物品交互图进行扰动,增强同一用户的表示一致性。CL4SRec: 应用于序列化推荐,通过增广序列对比建模用户兴趣动态。 多模态学习:

CLIP/ALIGN 的延展: 视频-文本、音频-文本等多模态对齐任务。

第六部分:挑战、前沿与展望

当前挑战:

负样本困境的终局? 如何高效处理假阴性?如何平衡数量与质量?无负样本方法能否彻底取代?理论与理解鸿沟: 对比学习为何有效的理论解释尚不完善(特别是无负样本方法如BYOL/SimSiam)。“特征崩溃”的机制?维度诅咒与特征解纠缠: 学到的特征是否最优解耦?如何防止高阶特征的纠缠?通用性强,但非最优? 对比学习通用表示在某个极其具体下游任务上,可能仍略逊于高质量标注下训练的监督模型(但前提是监督学习有足够数据)。计算成本: 大模型 + 长周期预训练依然消耗算力。数据增广策略: 非结构化数据(图、文本)如何设计有效的对比视角?需要领域知识。 活跃的研究方向:

理论基础: 尝试从互信息最大化、聚类、特征解纠缠等角度建立更严格的理论框架。长尾/不平衡数据的对比学习: 为少样本类设计专门的对比策略。层级对比学习: 在不同语义粒度上进行对比(如局部特征块)。模型架构融合: Transformer 与对比学习的深度结合。跨任务/跨模态迁移: 探索单一对比预训练模型服务多种跨领域任务的可能性。可解释性对比: 理解模型学到的不变特征到底是什么?解释模型决策依据。高效算法改进: 降低对大型计算集群的依赖。 未来展望:

AI预训练标准组件: 对比学习将成为构建基础大模型不可或缺的自监督学习技术。迈向更真实的“通用智能”: 通过多模态对比学习构建统一的世界模型表示。解锁冷启动与小数据领域: 在数据匮乏的科学领域(生物、化学、新材料)发挥巨大价值。“绿色AI”新范式: 通过更高效的自监督学习减少对海量标注数据的依赖。

结语:数据驱动范式的范式转移

对比学习代表着表示学习领域一次深刻的范式转变:从依赖人工定义标签的“被教”,转向利用数据内在关系进行“自省”的学习方式。 它极大地释放了无标签数据的潜力,为构建更通用、更鲁棒、更易迁移的人工智能模型奠定了坚实基础。

随着研究的深入和应用的拓展,对比学习必将持续引领数据科学和AI前沿。拥抱这一新范式,掌握其核心原理与实践方法,你将站在释放无标签数据巨大价值的浪潮之巅。

延伸探索:

经典论文: SimCLR, MoCo v1/v2, BYOL, SimSiam, SimCSE, CLIP, DINO, wav2vec 2.0。博客教程:

Lil’Log: [Understanding Contrastive Learning]theaisummer: [Contrastive Learning Series]PyTorch Lightning 的 SimCLR/MoCo 实现教程。 开源项目:

PyContrast (GitHub)VISSL (Facebook AI)SimCSE (Github) 书籍章节: 《动手学深度学习》最新版相关内容,《Representation Learning》专著相关章节。重要会议/期刊: NeurIPS, ICML, CVPR, ICLR, ACL, TPAMI, JMLR。

思考题:

在你的特定领域(如生物信息、金融量化、社交网络分析),存在哪些可以利用对比学习的无标签数据资源?你认为在不远的未来,对比学习会完全取代监督学习吗?为什么?对比学习面临的“假阴性”问题,在你的应用场景下会产生怎样的影响?是否有独特的解决方案?如何评估一个自监督对比学习模型学到的表示的通用性和质量?仅依靠下游任务的性能够吗?

期待你在评论区分享你的见解和实践经验!

相关文章

![[C++探索之旅] 第一部分第十课:文件读写,海阔凭鱼跃](https://img.dunling.com/blogimg/20251218/eeecf1bbcc2f49ce90d019837e9d14cf.jpg)