在AI界,提到“看得懂世界”的模型,几乎无人不知——它就是 YOLO。

这个名字听起来像一句口号——You Only Look Once(你只看一次),却彻底改变了机器“看图识物”的方式。

一、YOLO的诞生:让机器“快”起来

在YOLO出现之前,目标检测的主流方法是 R-CNN 系列。

它的做法很“笨”:

- 先从图片中截出上千个可能区域;

- 再逐一送进卷积神经网络识别;

- 最后再合并结果。

这种方法虽然准,但慢得惊人——检测一张图可能要几秒钟。

而YOLO的作者 Joseph Redmon 想法很简单:

“为什么不让神经网络一次就看完整张图?”

于是,2015年,第一代 YOLO v1 横空出世。

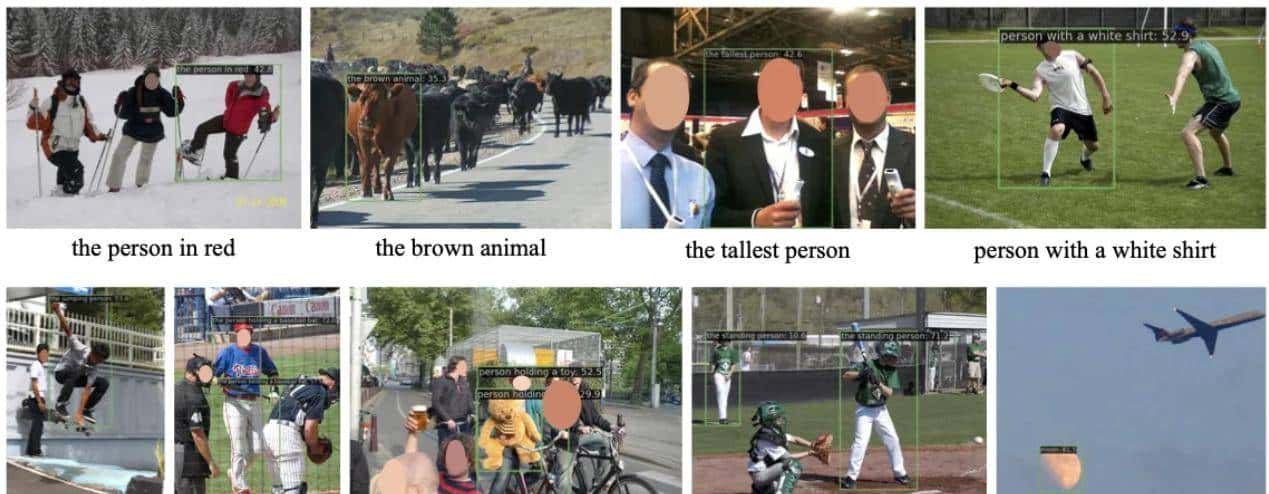

它将“检测”与“分类”整合进一个端到端(End-to-End)网络,把图像划分成网格,每个网格预测目标的位置和类别,只需一次前向传播,就能完成目标检测!

这就是“You Only Look Once”的由来。

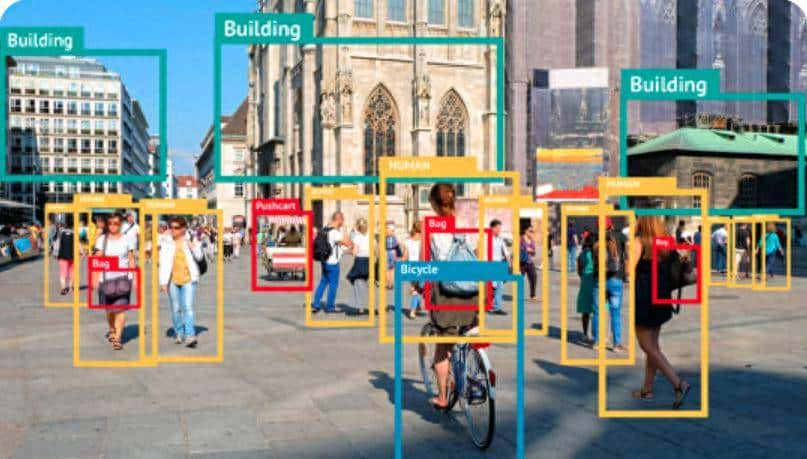

二、YOLO的核心思想:从“检测”到“感知”

YOLO的核心创新有三点:

- 端到端检测:不再依赖候选区域算法,一次性完成预测。

- 全图上下文:直接看整张图,理解物体间关系,列如“人骑在自行车上”。

- 实时性革命:在GPU上能实现每秒 45 帧以上——真正意义的“实时检测”。

三、从YOLOv1到YOLOv12:十年的进化之路

YOLO的演进几乎代表了整个人工智能视觉领域的技术脉络。

|

版本 |

年份 |

特点 |

|

YOLO v1 |

2015 |

开创端到端实时检测 |

|

YOLO v2 / v3 |

2016–2018 |

引入BatchNorm、Darknet-53骨干,更准更稳 |

|

YOLO v4 |

2020 |

CSPNet结构 + 数据增强,精度飞跃 |

|

YOLO v5 |

2020 |

Ultralytics团队维护,PyTorch实现,易用性爆棚 |

|

YOLO v7 |

2022 |

速度与精度兼顾的工业级版本 |

|

YOLO v8 |

2023 |

新架构 + ONNX支持,推理更灵活 |

|

YOLO v9 / v10 |

2024 |

引入可变形卷积与无锚点检测,性能再突破 |

|

YOLO v12 |

2025 |

深度融合注意力机制,重构网络架构,在检测速度与精度上实现了新的平衡与突破 |

截至2025年初,YOLOv12 已成为业界公认的下一代轻量化目标检测框架,在多模态感知(视觉 + 语义 + 时序)任务中展现出惊人的性能潜力。

四、YOLO的应用:从地面到天空

由于“快又准”,YOLO几乎无处不在:

- 无人驾驶:识别行人、车辆、红绿灯;

- 工业检测:识别瑕疵、异物;

- 无人机巡检:目标定位、地物识别;

- 手机AI相机:实时人脸识别与美颜;

- 空天电磁监测:结合AI识别信号源与干扰源;

- 生态保护:监测野生动物活动;

- 安全防范:入侵检测、行为分析。

一句话:凡是有“视觉”的地方,都能看到YOLO的身影。

五、YOLO背后的启示:AI的“速度哲学”

如今的YOLO,已经是AI视觉的代名词 —— 一套能跑在手机、无人机、边缘计算板卡,甚至FPGA上的“轻量级智慧”。YOLO不只是一个算法,更是一种AI哲学。

它告知我们:

“不是越复杂的模型越好,而是越高效的模型越接近现实。”

在AI时代,快,不仅代表速度,更代表实时反馈的智能。

当YOLO让机器能“看懂世界”,

也为AI打开了从离线计算 → 实时感知的大门。

相关文章